Google最近發佈了他們最新的AI模型Gemini 1.5,具備高達100萬token上下文窗口的“試驗性”功能。

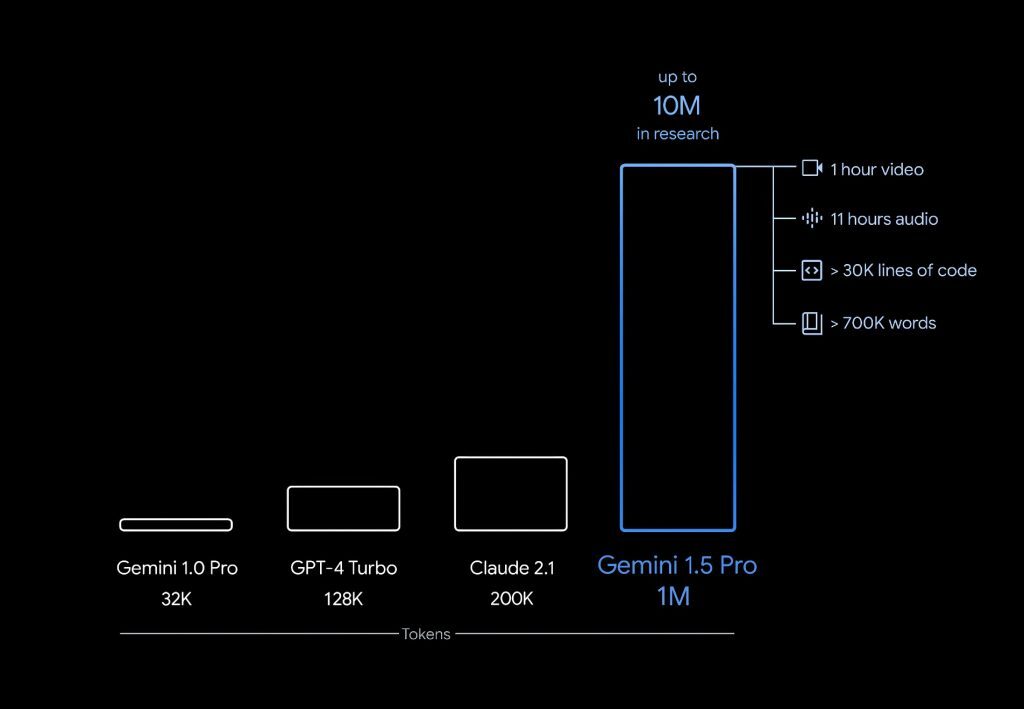

Gemini 1.5的新功能,包括能夠輕鬆處理長達100萬token的文本段落,從而更深入地理解上下文及其含義。相比之下,之前的AI系統如Claude 2.1和GPT-4 Turbo,就有些相形見絀了,它們的token處理上限分別是20萬和12.8萬。

Google研究人員在一篇技術文檔中表示「Gemini 1.5 Pro在跨模式的長上下文檢索中,實現了近乎完美的回憶功能。這一突破不僅提升了長文檔QA、長視頻QA,和長上下文ASR的最新水平,還在一系列參數基準上,達到了或超越了Gemini 1.0 Ultra的先進水平。」

Google最新模型的效率提升,主要歸功於創新式的Mixture-of-Experts (MoE)架構。

Google DeepMind 的行政總裁 Demis Hassabis解釋說:「傳統的Transformer功能就像一個大型的神經網絡,而MoE模型則是被分解成更小的‘專家’神經網絡。」這種架構讓模型能夠根據輸入內容的類型,選擇性地激活與其最相關的專家路徑,從而極大地提高了模型的效率。

為了證明Gemini 1.5的強大功能,Google展示了其在處理阿波羅11號飛行記錄(包含32.6914萬token),和啞劇電影(包含68.4萬token)時的表現。在這些示例中,Gemini 1.5不僅能夠準確理解上下文,還能針對具體問題,給出精確的回答。

目前,Google正在向開發者和企業,提供免費的Gemini 1.5有限預覽版,其中包括100萬個token的上下文窗口功能。未來,這一功能將逐步向公眾開放,同時還將推出12.8萬個token版本,並公佈定價細節。

儘管100萬token的功能目前仍處於試驗階段,但如果Gemini 1.5能夠兌現其早期承諾的功能,那麼它有望成為AI理解現實世界中、複雜文本能力的新標杆。